مدل GPT-OSS جدیدترین دستاورد شرکت OpenAI در حوزه هوش مصنوعی متنباز است. OpenAI با معرفی GPT-OSS (مخفف GPT Open-Source یا GPT متنباز) برای اولین بار پس از GPT-2، وزنهای یک مدل زبانی بزرگ را بهصورت آزاد منتشر کرده است. این اقدام، به توسعهدهندگان و کسبوکارها اجازه میدهد یک مدل قدرتمند هوش مصنوعی را بر روی سختافزار خودشان اجرا و شخصیسازی کنند.

در این مقاله از ایلاچت به معرفی هر دو نسخه GPT-OSS که اخیرا منتشر شدهاند میپردازیم، ویژگیهای کلیدی آنها را بررسی میکنیم، مقایسهای با دیگر مدلهای معروف انجام میدهیم، حداقل سختافزار مورد نیاز را بیان کرده و نحوه نصب و استفاده از این مدلها را توضیح میدهیم.

فهرست مطالب

GPT-OSS چیست؟

OpenAI خانوادهی مدل زبانی بزرگ GPT-OSS (جیپیتی اپن سورس) را بهصورت متنباز و تحت مجوز Apache 2.0 عرضه کرده است. این اولین باری است که OpenAI پس از مدل GPT-2 (در سال ۲۰۱۹) یک مدل زبان بزرگ را با وزنهای آزاد منتشر میکند. انتشار GPT-OSS تحول بزرگی ایجاد کرده است، زیرا پیش از آن، OpenAI مدلهای پیشرفتهی خود مانند GPT-3.5 و GPT-4 را فقط از طریق API و بهصورت بسته ارائه میداد. اما اکنون با GPT-OSS، کنترل کامل به دست کاربران بازگشته است؛ شما میتوانید این مدلها را بهصورت محلی یا روی سرورهای خود اجرا کرده و مطابق نیازتان تنظیم کنید.

OpenAI این حرکت را با هدف دموکراتیک کردن هوش مصنوعی و فراهمکردن دسترسی عمومی به مزایای آن انجام داده است. بسیاری از کسبوکارها به دلیل نگرانیهای مربوط به حریم خصوصی داده یا هزینهها، ترجیح میدهند مدلهای هوش مصنوعی را روی زیرساخت خود اجرا کنند. به همین دلیل، OpenAI مدل GPT-OSS را برای تحقق این هدف معرفی کرده است. این شرکت اعلام کرده که GPT-OSS امکان استفادهای ایمن، مسئولانه و آزادانه از مدلهای زبانی را فراهم میکند. این مدلها علاوه بر داشتن مزایای متنباز بودن، از نظر کارایی و کیفیت نیز توان رقابت با بسیاری از مدلهای بسته را دارند.

بیشتر بخوانید: GPT-5 رونمایی شد: مدل جدید OpenAI با جهشی بزرگ در هوش مصنوعی

معرفی دو نسخه GPT-OSS: مدلهای ۲۰B و ۱۲۰B

OpenAI دو مدل در خانواده GPT-OSS منتشر کرده است: GPT-OSS-20B و GPT-OSS-120B. این دو مدل از لحاظ اندازه و توان پردازشی متفاوتند تا نیازهای گوناگون را پوشش دهند:

معرفی مدل GPT-OSS-20B

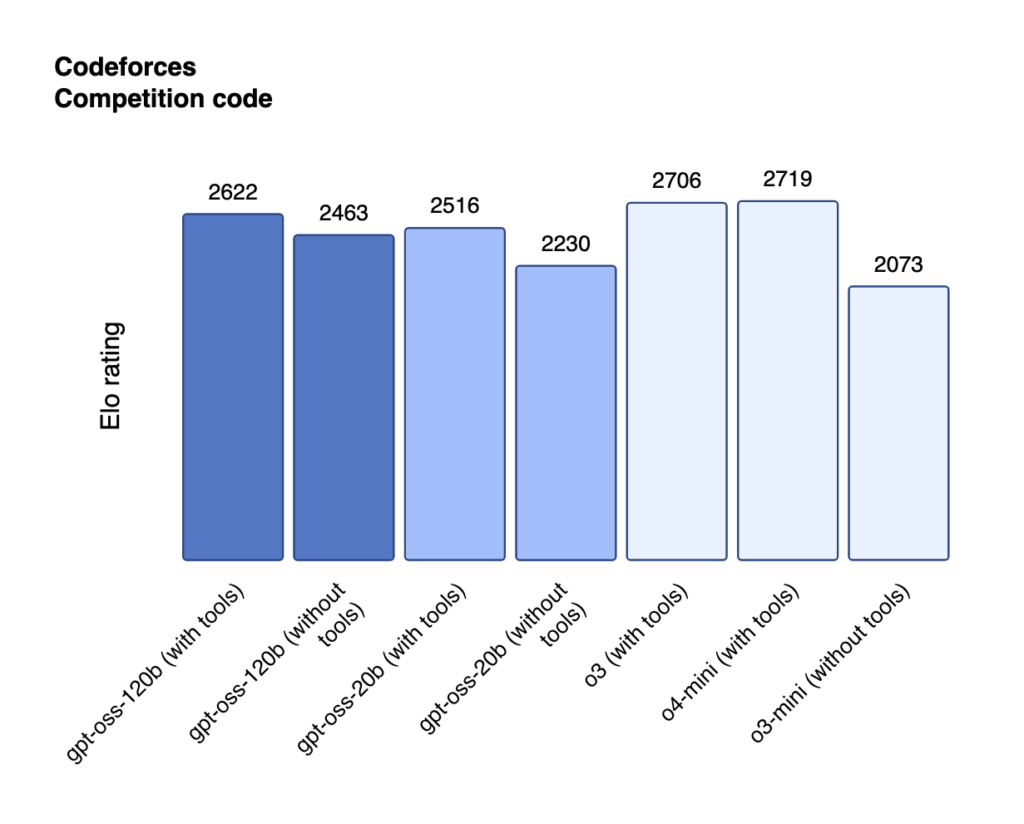

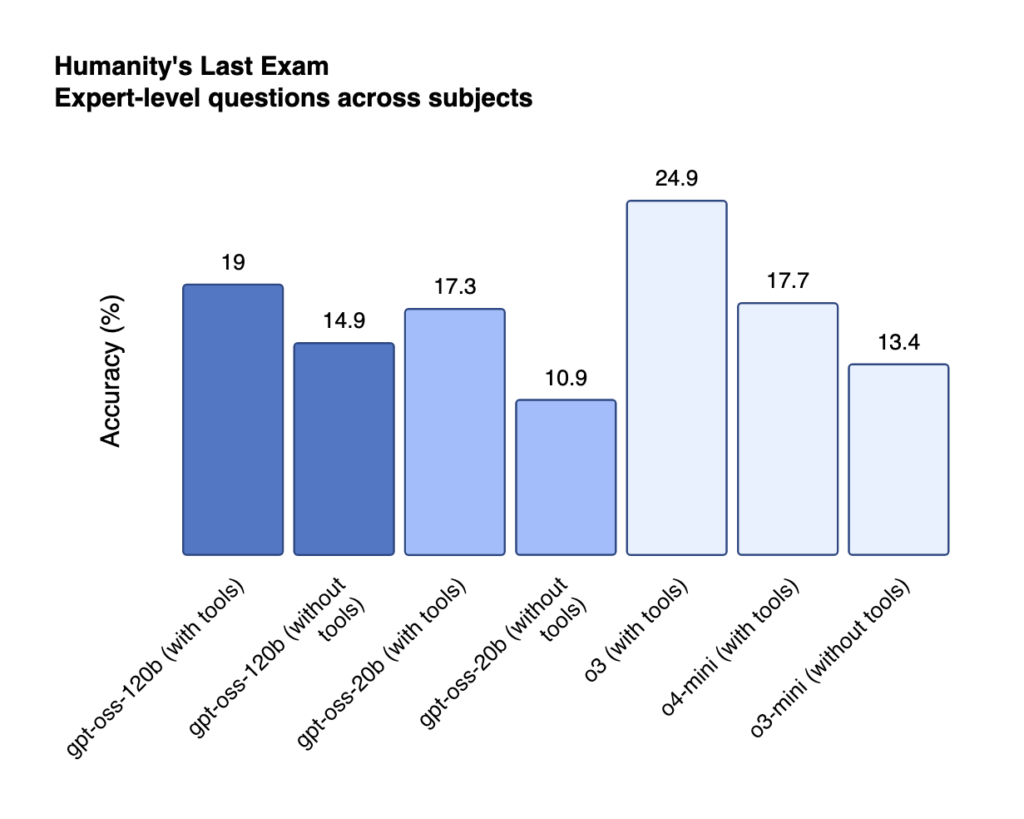

GPT-OSS-20B دارای حدود ۲۱ میلیارد پارامتر است. این نسخه جمعوجورتر و بهینهتر بوده و میتواند روی سختافزارهای معمولیتر نیز اجرا شود. GPT-OSS-20B تنها به حدود ۱۶ گیگابایت حافظه (VRAM) نیاز دارد، بنابراین حتی روی یک کارت گرافیک ردهبالای مصرفی (مثل RTX با ۱۶ گیگابایت) یا سیستمهای دسکتاپ قابل اجراست. با اینکه این مدل کوچکتر است، عملکرد آن قابلتوجه است. طبق ارزیابیهای OpenAI، مدل ۲۰B روی وظایف استاندارد، نتایجی در حد GPT-3 (نسخه کوچک OpenAI o3-mini) به دست میدهد. این یعنی برای کاربردهای روزمره و حتی اجرای محلی روی لپتاپهای قدرتمند، مدل ۲۰B گزینهای ایدهآل است. کاربران گزارش کردهاند که این مدل روی لپتاپی مانند مکبوک با ۳۲ گیگابایت RAM تنها حدود ۱۲ گیگابایت رم مصرف کرده و بدون مشکل اجرا شده است؛ موضوعی که بهینهسازی عالی آن را نشان میدهد.

معرفی مدل GPT-OSS-120B

GPT-OSS-120B دارای حدود ۱۱۷ میلیارد پارامتر است که آن را به یک مدل عظیم و قدرتمند تبدیل میکند. این نسخه برای کارهای پیچیدهتر و استدلال عمیق طراحی شده است. GPT-OSS-120B به طور معمول نیاز به سختافزار قویتری دارد و بهترین عملکرد خود را روی یک کارت گرافیک دیتاسنتری نظیر NVIDIA H100 با ۸۰ گیگابایت حافظه نشان میدهد. البته میتوان آن را روی چند GPU کوچکتر نیز توزیع کرد (مثلا دو GPU هر کدام ۴۰GB). مدل ۱۲۰B در ارزیابیهای OpenAI عملکردی نزدیک به GPT-4 (نسخه o4-mini) ارائه داده است. به بیان دیگر، این مدل متنباز در انجام وظایف استدلالی تقریبا همتراز با یکی از نسخههای پیشرفتهی GPT-4 عمل کرده و موفقیتی بزرگ را برای جامعهی متنباز رقم زده است. البته اجرای مدل بزرگ به منابع قابلتوجهی نیاز دارد و بیشتر مناسب سرورهای قدرتمند یا خدمات ابری است.

مقایسه دو مدل GPT-OSS-120B و GPT-OSS-20B

| ویژگی | GPT-OSS-20B | GPT-OSS-120B |

|---|---|---|

| تعداد پارامتر | ~۲۱ میلیارد | ~۱۱۷ میلیارد |

| نیاز حافظه (VRAM) | حدود ۱۶ گیگابایت | حدود ۸۰ گیگابایت (یا دو GPU × 40GB) |

| قابل اجرا روی | دسکتاپها، لپتاپهای قدرتمند (مثلا مکبوک) | سرورها، GPUهای دیتاسنتری (مثلا NVIDIA H100) |

| عملکرد نسبی | معادل GPT-3 (o3-mini) | نزدیک به GPT-4 (o4-mini) |

| مناسب برای | کاربردهای روزمره، اجرای محلی | کارهای پیچیده، استدلال عمیق |

| معماری استفادهشده | Mixture-of-Experts (MoE) | Mixture-of-Experts (MoE) |

| پارامتر فعال در هر مرحله | ~۳.۶ میلیارد | ~۵.۱ میلیارد |

| فشردهسازی وزنها | فرمت ۴-بیتی (MXFP4) | فرمت ۴-بیتی (MXFP4) |

| مزیت اصلی | بهینه، سبک، قابل اجرا روی سختافزار معمولی | قدرتمند، نزدیک به GPT-4، برای سرورها |

هر دو مدل GPT-OSS از تکنیک پیشرفته Mixture-of-Experts یا MoE بهره میبرند. در این معماری، به جای فعالسازی همه پارامترها برای هر ورودی، تنها بخشی از «متخصصها» فعال میشوند (برای مدل ۲۰B حدود ۳٫۶ میلیارد و برای ۱۲۰B حدود ۵٫۱ میلیارد پارامتر در هر مرحله فعال هستند). این معماری هوشمندانه به مدل امکان میدهد با داشتن پارامترهای بسیار زیاد، همچنان کارآمد و سریع عمل کند و حافظه کمتری اشغال نماید. علاوه بر این، OpenAI وزنهای این مدلها را به صورت ۴-بیتی (فرمت MXFP4) کمفشرده کرده است که باز هم موجب کاهش مصرف حافظه و افزایش سرعت شده است. نتیجهی این بهینهسازیها آن است که مدل ۱۲۰B بر خلاف اندازه عظیمش، روی یک GPU با حافظه ۸۰GB قابل اجراست و مدل ۲۰B را میتوان با یک GPU 16GB (یا معادل آن حافظه سیستم) راهاندازی کرد.

ویژگیها و قابلیتهای کلیدی GPT-OSS

مدلهای GPT-OSS بهگونهای طراحی شدهاند که در کاربردهای واقعی عملکرد قدرتمندی ارائه دهند. در ادامه به مهمترین قابلیتها و ویژگیهای این مدلها اشاره میکنیم:

۱. توانایی استدلال و زنجیره تفکر (Chain-of-Thought)

GPT-OSS در انجام وظایف پیچیده که نیازمند استدلال چندمرحلهای است بسیار تواناست. این مدل قادر است مسائل را مرحله به مرحله حل کند و حتی رشته استدلال خود را (در صورت نیاز) به صورت گامبهگام تولید نماید. برای مثال در حل مسائل ریاضی یا برنامهنویسی، میتواند منطق خود را توضیح دهد و به نتیجه برسد. این ویژگی حاصل آموزش مدل با دادههای خاص و الهامگرفته از پیشرفتهترین مدلهای داخلی OpenAI است.

۲. دقت در پیروی از دستورالعملها

این مدلها به شکل ویژه برای دستورپذیری و فهم دقیق درخواست کاربر آموزش داده شدهاند. در نتیجه، GPT-OSS میتواند به خوبی به پرسشها پاسخ دهد، خلاصهسازی کند، محتوای تولیدی را بر اساس راهنماییهای کاربر تنظیم کند و به طور کلی تعامل طبیعی و مفیدی شبیه ChatGPT داشته باشد.

۳. قابلیت استفاده از ابزارها و انجام وظایف عاملی (Agentic)

یکی از نقاط قوت GPT-OSS توانایی آن در استفاده از ابزارهای خارجی نظیر جستجوی وب، اجرای کد پایتون یا فراخوانی توابع در حین پاسخدهی است. این مدلها برای ادغام در کار جریانهای عاملی (agentic workflows) طراحی شدهاند؛ به این معنی که میتوانند به عنوان مغز متفکر رباتهای گفتگو یا دستیارهای هوشمند عمل کنند که در حین تعامل، به ابزارهایی مانند پایگاههای داده، APIها یا مرورگر وب دسترسی دارند. GPT-OSS حتی قابلیت جدید few-shot function calling (فراخوانی توابع با نمونههای کم) را به خوبی پشتیبانی میکند، یعنی میتوان با چند نمونه به آن یاد داد چگونه توابع خاصی را فراخوانی کرده و پاسخهای ساختیافته ایجاد کند. این ویژگی برای ساخت چتباتهای کاربردی که نیاز به انجام کار (مانند رزرو، محاسبات، استخراج اطلاعات و غیره) دارند بسیار ارزشمند است.

بیشتر بخوانید: هوش مصنوعی عاملی (Agentic AI) چیست و چگونه کار میکند؟

۴. پنجره ورودی/خروجی طولانی (کانتکست بلند)

مدلهای GPT-OSS از کانتکست ۱۳۱ هزار توکن پشتیبانی میکنند. این عدد بسیار فراتر از استاندارد رایج (مثلا ۴۰۰۰ یا ۸۰۰۰ توکن) است و حتی از برخی مدلهای بسته نظیر GPT-4 با ۳۲k توکن نیز بیشتر است. به زبان ساده، GPT-OSS میتواند متون بسیار طولانی را در ورودی بپذیرد و درباره آن استدلال یا خلاصهسازی کند، یا پاسخهایی تولید کند که خود شامل متن بلندی باشد. این ویژگی برای کاربردهایی نظیر پردازش اسناد حجیم، چتهای بلندمدت با کاربر، یا ترکیب دادههای زیاد برای پاسخدهی (مانند دریافت چندین مقاله علمی و پاسخ به سوال بر اساس مجموعه آنها) بسیار مفید است.

۵. بازدهی بالا و هزینه اجرای پایین

به لطف معماری MoE و کوانتیزهسازی ۴-بیتی، GPT-OSS به شکل بهینهای از منابع سختافزاری استفاده میکند. OpenAI اشاره کرده که این مدلها سریع و کمهزینه هستند و حتی GPT-OSS-120B با وجود بزرگی، زمان پاسخدهی بسیار سریعی دارد. در واقع معماری Mixture-of-Experts باعث کاهش تاخیر (Latency) شده و مدل ۱۲۰B را قادر ساخته تا برای کاربردهای بلادرنگ مانند چت و تصمیمگیری لحظهای مناسب باشد. این بدان معناست که کسبوکارها میتوانند بدون نیاز به خوشههای عظیم گرانقیمت، مدل را برای سرویسهای آنی به کار گیرند.

۶. قابلیت شخصیسازی و Fine-tuning

از آنجا که GPT-OSS متنباز است، سازمانها میتوانند آن را با دادههای اختصاصی صنعت خود مدل را Fine-tune کنند تا عملکردش در وظایف ویژه بهبود یابد. بر خلاف مدلهای بسته که دسترسی به وزنها وجود ندارد، اینجا میتوانید مدل را روی دادههای خصوصی شرکت خود تنظیم کنید و یک نسخه متخصص در حوزه کاری خود داشته باشید. همچنین امکان کمحجمسازی مدل (مثلا از طریق روشهایی چون LoRA/QLoRA) نیز وجود دارد تا مدل برای اجرا روی سختافزارهای ضعیفتر مناسبتر شود. حتی میتوان بخشهایی از مدل را تغییر داد یا معماری آن را برای نیازهای خاص اصلاح کرد که همگی به لطف متنباز بودن میسر است.

۷. استانداردهای ایمنی و اخلاقی

OpenAI اهمیت ویژهای به ایمنی مدلهای GPT-OSS داده است. پیش از انتشار، این مدلها تحت آموزشهای ایمنی پیشرفته قرار گرفته و سپس بهطور سختگیرانه ارزیابی شدهاند. برای اطمینان بیشتر، تیم OpenAI حتی یک نسخه دستکاریشده و بدخواهانه از GPT-OSS-120B را آزمایش کرده تا ببیند آیا میتوان از طریق ریزآموزی مخرب، مدل را به رفتارهای خطرناک واداشت یا خیر. نتیجه دلگرمکننده بود: حتی با چنین ترفندهایی مدل به سطوح خطرناک دست نیافت و تواناییهای مخرب بالایی نشان نداد. OpenAI اعلام کرده که عملکرد ایمنی GPT-OSSها در حد مدلهای بسته اخیر خودشان است. بنابراین توسعهدهندگان میتوانند از استانداردهای ایمنی مشابه GPT-4 در این مدلهای متنباز بهرهمند شوند. البته OpenAI همراه با این مدل، یک سیاست استفاده نیز منتشر کرده که کاربران را به استفاده قانونی و مسئولانه ترغیب میکند (برای مثال، جلوگیری از کاربردهای آسیبرسان یا غیرقانونی).

۸. مجوز آزاد و بدون محدودیتهای تجاری

همانطور که پیشتر اشاره شد، OpenAI مدل GPT-OSS را تحت مجوز Apache 2.0 منتشر کرده است. این مجوز به شما اجازه میدهد آزادانه حتی در پروژههای تجاری از مدل استفاده کنید، آن را تغییر دهید یا به اشتراک بگذارید، بدون نگرانی از مسائل حقوقی پیچیده. برخلاف برخی مدلهای متنباز (مانند بعضی نسخههای LLaMA از متا) که استفادهی تجاری را محدود کردهاند، OpenAI رویکردی کاملا آزاد و باز در پیش گرفته است. تنها شرط استفاده، پایبندی به قوانین و پرهیز از سوءاستفاده است؛ چیزی که در اصل به معنای رعایت اصول استفادهی مسئولانه از فناوری محسوب میشود.

بیشتر بخوانید: پروتکل زمینه مدل (MCP) چیست و چه نقشی در هوش مصنوعی دارد؟

مقایسه GPT-OSS با دیگر مدلهای معروف هوش مصنوعی

انتشار GPT-OSS توجه بسیاری را به خود جلب کرده، چرا که این مدلها رقیبی جدی برای همتایان معروف خود محسوب میشوند. در این بخش GPT-OSS را در زمینههای مختلف با چند مدل شاخص دیگر مقایسه میکنیم:

| معیار مقایسه | GPT-OSS | مدلهای بسته OpenAI | مدلهای متنباز دیگر |

|---|---|---|---|

| سطح دسترسی | کاملا متنباز | بسته و API محور | متنباز (اکثرا با محدودیتهای لایسنس) |

| مدل برجسته | GPT-OSS-120B و GPT-OSS-20B | GPT-4، GPT-3.5 | LLaMA 2 (70B)، Falcon (40B/180B)، Bloom و … |

| عملکرد در استدلال (بنچمارک) | 120B نزدیک به GPT-4 (o4-mini) | GPT-4 کامل همچنان قویترین است | GPT-OSS-120B در برخی موارد بهتر از LLaMA 2 و Falcon |

| مقایسه مدلهای کوچکتر | 20B همتراز با GPT-3 (o3-mini) | GPT-3.5 و GPT-3 | GPT-OSS-20B برتر از Falcon-40B و MPT-30B در برخی حوزهها |

| کاربرد در کدنویسی | عملکرد بسیار قوی در بنچمارکها | قوی (مخصوصا GPT-4) | عملکرد خوب، ولی پایینتر از GPT-OSS |

| قابلیت خودمیزبانی (Self-hosting) | بله، قابل اجرا روی سختافزار خودی | خیر، فقط از طریق API شرکت OpenAI | برخی مدلها بله، ولی معمولا نیازمند تنظیمات پیچیده |

| کنترل بر داده و امنیت | کامل (دادهها روی سیستم شما میماند) | وابسته به سرویسدهنده | تا حدی، بسته به لایسنس و مدل |

| انعطافپذیری و شخصیسازی | بله، قابل تغییر، بهینهسازی و تنظیم | خیر | برخی مدلها اجازه شخصیسازی محدود دارند |

| نیاز به منابع سختافزاری | متوسط (20B) تا بالا (120B) با امکان توزیع | نیاز ندارد (پردازش روی سرورهای OpenAI انجام میشود) | متوسط تا بالا، بستگی به مدل |

| وضعیت در بازار | نوظهور اما بسیار قدرتمند | پیشرو، تثبیتشده | رقابتی، ولی تحتالشعاع GPT-OSS قرار گرفتهاند |

مدلهای GPT-4 و نسخههای مختلف آن مانند ChatGPT به عنوان قویترین مدلهای زبانی شناخته میشوند که بهصورت بسته توسط OpenAI ارائه شدهاند. اما مدلهای متنباز نیز پیشرفت چشمگیری داشتهاند. مدل GPT-OSS-120B در ارزیابیهای داخلی OpenAI توانسته است از نظر توان استدلال به سطح مدل o4-mini از GPT-4 برسد، و مدل کوچکتر GPT-OSS-20B نیز عملکردی نزدیک به GPT-3 (نسخه o3-mini) داشته است. این موفقیتها نشان میدهد که بسیاری از کاربردهایی که قبلا فقط با GPT-4 ممکن بودند، اکنون با GPT-OSS نیز قابل اجرا هستند؛ بدون نیاز به اتصال به API بسته.

پیش از GPT-OSS، مدلهای متنبازی مانند LLaMA 2، Falcon و Bloom در دسترس بودند و LLaMA 2 با ۷۰ میلیارد پارامتر یکی از موفقترینها در سال ۲۰۲۳ بهشمار میرفت. اما با معرفی GPT-OSS-120B و استفاده از معماری Mixture-of-Experts (MoE)، OpenAI توانسته عملکردی بهتر یا برابر با این مدلها ارائه دهد. حتی مدل کوچکتر GPT-OSS-20B نیز در برخی زمینهها مانند برنامهنویسی، از مدلهایی مثل Falcon-40B و MPT-30B پیشی گرفته است. این امر نشاندهندهی پیشرفت چشمگیر مدلهای متنباز در رقابت با مدلهای بزرگ و بسته است.

یکی از برجستهترین مزیتهای GPT-OSS برای کسبوکارها، امکان خودمیزبانی (self-hosting) آن است. برخلاف مدلهای بسته که نیاز به اتصال به سرویس ابری دارند، GPT-OSS این قابلیت را به شرکتها میدهد که مدل را به صورت کامل روی زیرساخت خود اجرا کنند. این موضوع موجب کنترل کامل بر دادهها، حفظ حریم خصوصی، و کاهش نگرانیهای امنیتی میشود. همچنین محدودیتهایی مانند نرخ درخواست (Rate Limit) یا هزینههای متغیر استفاده دیگر مطرح نیستند، چرا که همه چیز روی سختافزار داخلی اجرا میشود. این استقلال از سیاستهای شرکتهای ارائهدهنده مدل، برای بسیاری از سازمانها مزیتی کلیدی محسوب میشود. افزون بر این، دسترسی به وزنهای مدل به شرکتها این امکان را میدهد که مدل را مطابق نیاز خود بهینهسازی یا شخصیسازی کرده و حتی نسخههای اختصاصی تولید کنند.

بیشتر بخوانید: دیپسیک: چالش جدید هوش مصنوعی برای انویدیا و غولهای فناوری

در کاربردهای خاص نیز GPT-OSS عملکرد درخشانی داشته است. برای مثال، در بنچمارکهای کدنویسی، مدلهای GPT-OSS به امتیازاتی دست یافتهاند که حتی از بسیاری از انسانها بالاتر است. در زمینههایی مانند خلاصهسازی متون، پاسخگویی به سوالات علمی یا پزشکی (نظیر HealthBench)، نیز این مدلها توانستهاند از برخی مدلهای تجاری مانند OpenAI o1 یا نسخه سازمانی GPT-4 بهتر عمل کنند.

این دستاوردها نشان میدهند که GPT-OSS نهتنها در تئوری، بلکه در عمل نیز به ردهی بهترین مدلهای زبانی نزدیک شده است. البته هر مدل نقاط ضعف خود را دارد و انتظار میرود با انتشار گزارشهای مستقل بیشتر، تصویر دقیقتری از جایگاه آنها بهدست آید. اما در مجموع، GPT-OSS اکنون بهعنوان یک بازیگر قدرتمند در کنار مدلهای بزرگی چون GPT-4، Claude 2 و LLaMA 2 مطرح شده و گزینههای جذابتری را پیش روی کسبوکارها و پژوهشگران قرار داده است.

حداقل سختافزار و سیستم مورد نیاز برای GPT-OSS

یکی از سوالات مهم برای پیادهسازی GPT-OSS این است که چه سختافزاری لازم داریم؟ خوشبختانه OpenAI با بهینهسازیهایی که انجام داده (خصوصا کوانتیزهسازی ۴-بیتی و معماری MoE)، اجرای این مدلها را در محدوده سختافزار معقول ممکن کرده است. در ادامه حداقل نیازمندیها و پیشنهادات سختافزاری را بررسی میکنیم:

| ویژگی/مدل | GPT-OSS-20B | GPT-OSS-120B |

|---|---|---|

| حداقل VRAM برای GPU | 16 گیگابایت | 80 گیگابایت (مثلا NVIDIA H100/A100) |

| GPU پیشنهادی | RTX 4080 / 3090 / 4090 | 2×40GB GPU یا 4×24GB (مانند چند RTX 3090) |

| امکان اجرا روی CPU | بله، با RAM حدود 48GB و سرعت پایینتر | بسیار محدود یا غیرعملی |

| اجرای موفق روی لپتاپ | بله، روی مکبوک با 32GB RAM (12GB مصرف RAM) | خیر، مگر از طریق کلود یا چند GPU دیتاسنتری |

| مناسب برای | کسبوکارهای کوچک، ورکاستیشنهای پیشرفته | سازمانها و استارتاپهای با زیرساخت قدرتمند |

| گزینههای جایگزین | اجرای محلی، اجرای نیمهدقیق، استفاده از vLLM/Llama.cpp | استفاده از سرویس ابری یا اجاره GPU دیتاسنتری |

| حجم مدل در حالت کوانتیزهشده | قابل مدیریت (~16GB VRAM کافی) | چند ده گیگابایت، روی یک کارت 80GB قابل اجراست |

| نیاز در حالت بدون کوانتیزهسازی | حدود 48GB RAM | صدها گیگابایت حافظه |

| پشتیبانی از کتابخانههای بهینهسازی | بله (مانند vLLM، Llama.cpp، ROCm برای AMD) | بله |

برای اجرای GPT-OSS-20B کافی است یک کارت گرافیک با ۱۶ گیگابایت VRAM در اختیار داشته باشید. کارتهایی مثل RTX 4080 یا 3090 برای این کار مناسب هستند. حتی برخی کاربران توانستهاند این مدل را فقط با CPU اجرا کنند، البته با سرعت کمتر و نیاز به حدود ۴۸ گیگابایت RAM.

این مدل بهخوبی روی لپتاپهای قوی یا ورکاستیشنهای متوسط هم اجرا میشود. برای نمونه، یک مکبوک با ۳۲GB RAM و تراشه Apple Silicon (مثل M3 یا M4) توانسته GPT-OSS-20B را با مصرف تنها ۱۲GB RAM اجرا کند. همچنین این مدل با پردازندههای AMD و GPUهای پشتیبانیشده از طریق ROCm نیز قابل اجراست. در نتیجه، بسیاری از کاربران شخصی یا کسبوکارهای کوچک میتوانند این مدل را روی سیستم خودشان راهاندازی کنند.

در مقابل، GPT-OSS-120B به سختافزار بسیار قدرتمندتری نیاز دارد. یک GPU دیتاسنتری با ۸۰GB حافظه (مثل H100) بهترین گزینه است. اگر چنین کارتی در اختیار ندارید، میتوانید از چند کارت ضعیفتر (مثلا دو عدد ۴۰GB یا چهار عدد ۲۴GB) بهصورت ترکیبی استفاده کنید.

اگر زیرساخت لازم را ندارید، میتوانید مدل ۱۲۰B را روی سرویسهای ابری اجرا کنید. نسخه کوانتیزهشده این مدل حجم معقولی دارد و قابل مدیریت است، اما در حالت کامل ممکن است به صدها گیگابایت حافظه نیاز باشد.

در نهایت، فرمت کوانتیزهشدهی MXFP4 که GPT-OSS از آن استفاده میکند، روی کارتهای گرافیک جدیدتر بهتر پشتیبانی میشود؛ مثل سری H100 یا RTX 5000. اگر از کارت قدیمیتری استفاده میکنید، مدل بهطور خودکار به حالت bfloat16 سوییچ میکند که حافظه بیشتری مصرف میکند. با این حال، ابزارهایی مثل vLLM و Llama.cpp کمک میکنند حتی روی سختافزارهای متنوع، از جمله پردازندههای AMD (از طریق ROCm) و تراشههای Apple Silicon (M1، M2، M3، M4) نیز بتوانید GPT-OSS را با کارایی مناسب اجرا کنید.

راهنمای نصب و استفاده از GPT-OSS

پس از تامین سختافزار مناسب، گام بعدی راهاندازی و استفاده از GPT-OSS است. خوشبختانه OpenAI و جامعه متنباز، کار را برای توسعهدهندگان و حتی کاربران غیرمتخصص ساده کردهاند. در این بخش، روشهای مختلف استفاده از GPT-OSS را معرفی میکنیم:

روش ۱: استفاده از Hugging Face و Transformers

اگر با پایتون و برنامهنویسی آشنا هستید، راحتترین راه استفاده از GPT-OSS، کتابخانه Transformers از Hugging Face است. کافی است کتابخانهها را نصب کنید: (مشاهده داکیومنت در Hugging Face)

pip install transformers accelerateبرای بارگذاری مدل 20B:

from transformers import AutoTokenizer, AutoModelForCausalLM

tokenizer = AutoTokenizer.from_pretrained("openai/gpt-oss-20b")

model = AutoModelForCausalLM.from_pretrained(

"openai/gpt-oss-20b", device_map="auto", torch_dtype="auto"

)

inputs = tokenizer("متن یا سوال ورودی شما", return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))این کد مدل را بارگذاری کرده و آماده تولید متن میکند. مدل مانند سایر مدلهای Transformer عمل میکند و از قالب چت (role/message) نیز پشتیبانی دارد.

روش ۲: استفاده از API و ارائهدهندگان سرویس ابری

اگر دنبال سادهترین راه بدون نیاز به کدنویسی یا سختافزار قوی هستید:

- Hugging Face Inference Endpoints: با ساخت اکانت در Hugging Face و دریافت توکن، میتوانید مدل را به صورت سرویس ابری و حتی با API سازگار با OpenAI استفاده کنید. کافی است توکن را تنظیم و از نمونه کدهای پایتون یا جاوااسکریپت استفاده کنید.

- سرویسهای آماده دیگر (مانند Azure، AWS Bedrock): مدلهای GPT-OSS به این پلتفرمها هم اضافه شدهاند. اگر از سرویسهای ابری استفاده میکنید، میتوانید مدل را مانند سرویسهای OpenAI فراخوانی و مصرف کنید.

روش ۳: ابزارهای دسکتاپ (بدون نیاز به برنامهنویسی)

اگر به دنبال روشی ساده و بدون نیاز به برنامهنویسی برای استفاده از GPT-OSS هستید، ابزارهای دسکتاپی مانند LM Studio و Ollama انتخاب مناسبی هستند. این ابزارها با رابط گرافیکی کاربرپسند، امکان بارگذاری و استفاده از مدلهای زبان را تنها با چند کلیک فراهم میکنند.

LM Studio پس از نصب، به شما اجازه میدهد مدل GPT-OSS-20B را مستقیما جستجو و دانلود کنید. پس از بارگذاری مدل، کافی است وارد بخش Chat شوید و پرسش خود را وارد کنید تا پاسخ مدل را دریافت نمایید. این نرمافزار برای اجرا به حداقل ۱۳ گیگابایت رم نیاز دارد و قابلیت ارائه API محلی برای توسعهدهندگان را نیز دارد.

Ollama نیز ابزاری مشابه است که هم نسخه ترمینالی و هم رابط گرافیکی (ویندوز و مک) را ارائه میدهد. پس از نصب، میتوانید مدل مورد نظر را با دستور ollama pull gpt-oss:20b دریافت و با ollama run gpt-oss:20b اجرا کنید. Ollama از نسخههای فشرده مدلها پشتیبانی میکند و حتی کاربران مبتدی میتوانند با چند کلیک از آن استفاده کنند.

جمعبندی و توصیه نهایی

GPT-OSS فصل جدیدی را در دنیای هوش مصنوعی رقم زده است. اکنون کسبوکارهای آنلاین میتوانند یک مدل زبان بزرگ در کلاس GPT-4 را بدون وابستگی به APIهای بیرونی در اختیار داشته باشند. این مدلها با مجوز متنباز، عملکرد عالی، و نیاز سختافزاری قابل تامین، امکان پیادهسازی راهکارهای هوشمند را برای طیف گستردهای از شرکتها فراهم کردهاند. چه به دنبال ساخت یک چتبات پیشرفته برای پشتیبانی مشتری باشید، چه یک سیستم تحلیل داده متنی روی اطلاعات داخلی شرکت، GPT-OSS گزینهای است که ارزش بررسی را دارد.

با توجه به رویکرد OpenAI در آموزش ایمن این مدل و نتایج امیدوارکنندهای که در بنچمارکها مشاهده شده، میتوان به قابلیت اطمینان آن نیز امیدوار بود. در نهایت، ورود GPT-OSS را میتوان گامی به سود کاربران و توسعهدهندگان دانست؛ گامی که رقابت را بیشتر میکند، نوآوری را سرعت میبخشد و قدرت هوش مصنوعی را دمکراتیکتر از همیشه به دست مردم میسپارد.

در همین راستا، پلتفرمهایی مانند ایلاچت نیز با بهرهگیری از قدرت مدلهای زبانی، امکان راهاندازی سریع چتباتهای هوشمند را برای کسبوکارها فراهم کردهاند؛ راهکاری آماده برای آنهایی که میخواهند بدون پیچیدگی فنی، از مزایای GPT بهرهمند شوند.

بیشتر بخوانید: RAG چیست؟ معرفی کامل و کاربردهای آن

پرسشهای متداول

GPT-OSS یک خانواده مدل زبان بزرگ (LLM) است که OpenAI به صورت متنباز منتشر کرده است. این مدلها از نظر توانایی درک و تولید زبان شبیه ChatGPT هستند (حتی در برخی موارد در حد GPT-4)، اما برخلاف ChatGPT که یک سرویس ابری بسته است، GPT-OSS را میتوانید دانلود و روی سختافزار خود اجرا کنید. مزیت GPT-OSS در این است که کنترل کامل بر مدل و دادههای ورودی/خروجی دارید و میتوانید آن را مطابق نیازتان تغییر دهید یا ریزآموزی کنید.

نسخه کوچکتر یعنی GPT-OSS-20B را میتوان با یک کارت گرافیک نسبتا قوی که حداقل ۱۶ گیگابایت VRAM دارد اجرا کرد (مثلا RTX 4080). این نسخه حتی روی برخی سیستمهای غیر GPU با RAM بالا هم قابل اجراست (هرچند کندتر). نسخه بزرگتر GPT-OSS-120B معمولا به یک کارت سروری با حدود ۸۰ گیگابایت حافظه نیاز دارد (مثل NVIDIA H100). در صورت عدم دسترسی، میتوان از چند کارت کوچکتر به صورت ترکیبی استفاده کرد. همچنین سرویسهای ابری (Azure، AWS و غیره) این مدل را روی سختافزار مناسب برایتان اجرا میکنند، کافیست از خدمات آنها استفاده کنید.

بله، خود مدلهای GPT-OSS رایگان و متنباز هستند و OpenAI آنها را تحت مجوز Apache 2.0 منتشر کرده است. این به آن معناست که برای استفاده از مدل یا تغییر آن نیاز به پرداخت هزینه لایسنس ندارید. تنها هزینهای که متحمل میشوید مربوط به زیرساخت اجرای مدل است (مثلا هزینه برق و سختافزار یا سرور ابری). همچنین OpenAI یک سیاست استفاده منتشر کرده که بیشتر جنبهی توصیه به استفاده مسئولانه دارد و از شما میخواهد مدل را در چارچوب قوانین و به دور از مقاصد مخرب به کار ببرید. بنابراین تا زمانی که موارد قانونی و اخلاقی را رعایت کنید، در استفاده از GPT-OSS محدودیتی وجود ندارد و حتی برای کاربردهای تجاری هم کاملا آزاد است.

منابع: